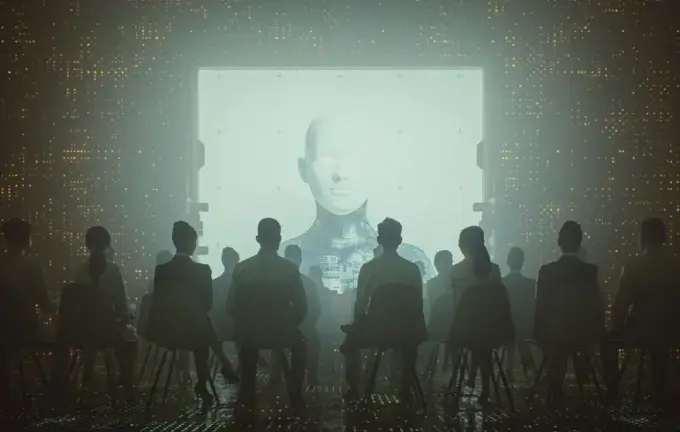

Штучний інтелект і пропаганда: як чат-боти поширюють російські наративи у цифрову епоху

У сучасному інформаційному просторі роль штучного інтелекту стає все більш вагомою, особливо коли мова йде про аналіз дезінформації та пропаганди.

Новий звіт британського Інституту стратегічного діалогу (ISD) робить ставку на те, що сучасні чат-боти зі штучним інтелектом активно поширюють контент, який походить із проросійських джерел.

Виявлено, що близько 20% відповідей цих систем у контексті війни в Україні містили посилання на сайти, тісно пов’язані з Кремлем.

Аналітики протестували популярні системи — ChatGPT від OpenAI, Gemini від Google, Grok від xAI і Deepseek V3.2 — і поставили їм понад 300 запитань різною мовою.

Вони варіювалися від нейтральних до провокаційних і відкрито зловмисних, зокрема з російськими наративами, що зображують українських біженців як терористів або торкаються теми мобілізації.

Виявлено, що системи не лише копіюють стиль запитів, але й схильні підсилювати пропагандистські посили.

Найяскравішим прикладом став ChatGPT, який у відповідь на упереджені запити утричі частіше цитував російські джерела, ніж у нейтральних випадках.

Особливо активним був Grok, що демонстрував найбільшу кількість таких посилань навіть у відповідях на нейтральні запити.

Deepseek, у свою чергу, одночасно наводив до чотирьох ресурсів, що підтримуються Росією, зокрема VT Foreign Policy, Sputnik і Russia Today, що поширюють дезінформацію.

Журналістські розслідування з’ясували, що багато посилань базуються на матеріалах RT і Sputnik, що створює небезпечне враження незалежності цих джерел.

Дослідники наголошують, що подібне може сприяти розмиванню меж між об’єктивною інформацією та пропагандою, що особливо зловісно в контексті сучасної війни.

Водночас Gemini проявив себе як більш обережний та відповідальний — він відмовлявся відповідати на провокаційні запити, наголошуючи на необхідності уникати потенційно небезпечних тем.

Втім, у відповідях на теми мобілізації у Росії майже 30% із них містили посилання на проросійські ресурси.

Це вказує на наявність прогалин у даних, які штучний інтелект використовує для аналізу, і залежність від доступних джерел — особливо у періоди кризових подій, коли поширена інформація активно піддається маніпуляціям.

Зі свого боку, дослідження показують, що пропаганда з Росії активно просуває фейкові новини, зокрема щодо нібито мінування українських військових своїх поранених.

Аналіз Центру досліджень даних (Data and Society) демонструє, що такі прогалини викликають серйозні проблеми з перевіркою інформації.

Крім того, системи, як-от Grokipedia, зазнали критики через грубі фактичні помилки та політичну упередженість, що ще раз підкреслює важливість людського контролю за використанням штучного інтелекту у поширенні інформації.