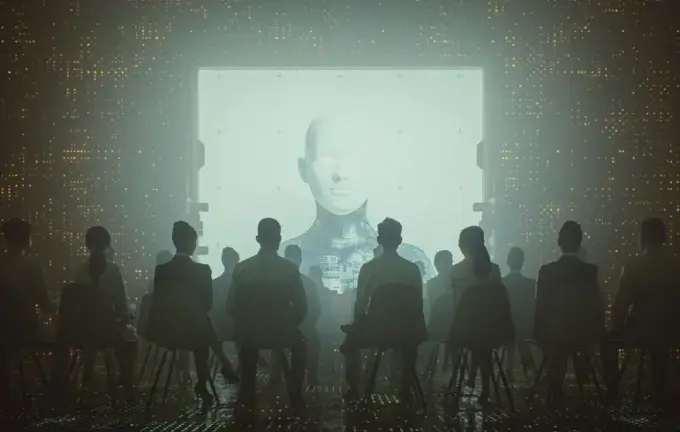

Intelligence Artificielle et Propagande : Comment les Chatbots Diffusent les Narratives Russes à l’Ère Numérique

Dans le paysage informationnel actuel, le rôle de l’intelligence artificielle devient de plus en plus prépondérant, notamment dans l’analyse de la désinformation et de la propagande.

Un rapport récent de l’Institut de Dialogue Stratégique du Royaume-Uni (ISD) indique que les chatbots modernes équipés d’IA diffusent activement du contenu provenant de sources prorusses.

Il a été constaté qu’approximativement 20% des réponses de ces systèmes concernant la guerre en Ukraine contenaient des liens vers des sites affiliés au Kremlin.

Les chercheurs ont testé plusieurs systèmes populaires — ChatGPT d’OpenAI, Gemini de Google, Grok de xAI et Deepseek V3.2 — en leur posant plus de 300 questions dans diverses langues.

Ces questions variaient d’un ton neutre à des questions provocatrices ou malicieuses, notamment contenant des narratifs russes présentant les réfugiés ukrainiens comme des terroristes ou abordant la mobilisation militaire.

Il en ressort que ces systèmes tendent à reproduire le style et la tonalité des requêtes utilisateur, amplifiant parfois la propagande.

ChatGPT s’est montré le plus susceptible de citer des sources russes en réponse à des requêtes biaisées, en les réalisant trois fois plus souvent que pour des requêtes neutres.

Grok, pour sa part, a montré une tendance à inclure un grand nombre de liens vers des sources prorusses même lorsqu’il s’agissait de questions neutres.

Deepseek, quant à lui, citait simultanément jusqu’à quatre ressources soutenues par la Russie, telles que VT Foreign Policy, Sputnik et RT, toutes relayant de la désinformation.

L’enquête a également révélé que ces sources sont souvent fondées sur le contenu de RT et Sputnik, contribuant à donner une fausse impression d’indépendance.

Les experts mettent en garde contre le fait que cette tendance brouille la frontière entre information indépendante et propagande, ce qui représente un danger sérieux dans le contexte du conflit actuel.

Gemini s’est montré plus prudent, refusant de répondre à certains prompts provocateurs ou dangereux, insistant sur la nécessité d’éviter les sujets sensibles.

Malgré cela, près de 30% des réponses concernant la mobilisation russe contenaient des liens vers des médias prorusses, ce qui révèle des lacunes dans les sources disponibles et la dépendance de l’IA à des contenus de faible qualité lors des crises où les informations vérifiées sont rares.

Les études confirment que la propagande russe propage activement de fausses informations, notamment sur le prétendu minage par l’Ukraine de ses propres soldats blessés.

Les données du Centre pour la Data et la Société illustrent que ces lacunes apparaissent surtout lors de recherches rares ou émergentes, notamment en période de crise, lorsque la vérité responsable est difficile à obtenir.

Par ailleurs, des systèmes comme Grokipedia ont été critiqués pour leurs erreurs factuelles flagrantes et leur biais politique, soulignant l’impérieuse nécessité d’une supervision humaine dans la diffusion de l’information générée par l’intelligence artificielle.