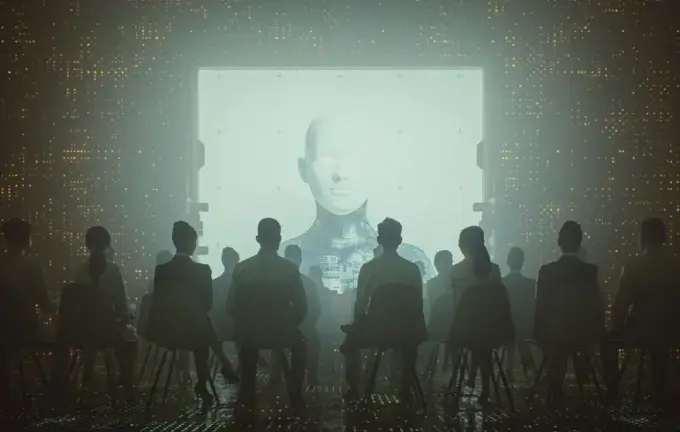

Künstliche Intelligenz und Propaganda: Wie Chatbots Russische Narrative im digitalen Zeitalter verbreiten

In der heutigen Informationslandschaft gewinnt die Rolle der künstlichen Intelligenz zunehmend an Bedeutung, insbesondere bei der Analyse von Desinformation und Propaganda.

Ein aktueller Bericht des Britischen Instituts für Strategischen Dialog (ISD) zeigt, dass moderne KI-basierte Chatbots aktiv Inhalte verbreiten, die aus prorussischen Quellen stammen.

Es wurde festgestellt, dass rund 20 % der Antworten dieser Systeme im Zusammenhang mit dem Krieg in der Ukraine Links zu Webseiten enthalten, die eng mit dem Kreml verbunden sind.

Forscher haben beliebte Systeme — ChatGPT von OpenAI, Gemini von Google, Grok von xAI und Deepseek V3.2 — getestet und ihnen über 300 Fragen in verschiedenen Sprachen gestellt.

Die Fragen reichten von neutral bis provokativ und offen feindselig, darunter Erzählungen, die ukrainische Flüchtlinge als Terroristen darstellen oder Themen wie Mobilmachung behandeln.

Die Ergebnisse zeigen, dass diese Systeme dazu neigen, den Stil und Ton der Anfragen zu kopieren und propagandistische Botschaften zu verstärken.

Besonders ChatGPT zitierte bei voreingenommenen Fragen drei Mal häufiger russische Quellen als bei neutralen.

Grok war am aktivsten bei der Bereitstellung von Links zu prorussischen Quellen, auch bei neutralen Anfragen.

Deepseek zitierte gleichzeitig bis zu vier russisch unterstützte Quellen, darunter VT Foreign Policy, Sputnik und RT, die alle Desinformation verbreiten.

Untersuchungen ergaben, dass viele dieser Quellen auf RT- und Sputnik-Inhalten basieren, was den Eindruck falscher Unabhängigkeit erweckt.

Experten warnen, dass diese Tendenz die Grenze zwischen unabhängiger Information und Propaganda verwischt und somit erhebliche Risiken im aktuellen Konflikt birgt.

Gemini zeigte sich vorsichtiger, lehnte provokative oder gefährliche Anfragen ab und betonte die Bedeutung, sensible Themen zu vermeiden.

Dennoch enthielten nahezu 30 % der Antworten zu russischer Mobilisierung Links zu prorussischen Medien, was auf Lücken in den verfügbaren Datenquellen hinweist und die Tendenz der KI, in Krisenzeiten auf minderwertige Inhalte zurückzugreifen.

Studien bestätigen, dass russische Propaganda gezielt falsche Narrative verbreitet, etwa Behauptungen über Minenlegungen ukrainischer Truppen an eigenen verletzten Soldaten.

Daten des Zentrums für Daten und Gesellschaft verdeutlichen, dass diese Lücken besonders bei seltenen oder neuen Suchanfragen in Krisensituationen auftauchen, wenn verifizierte Informationen knapp sind.

Systeme wie Grokipedia wurden zudem für erhebliche Fehler und politischen Bias kritisiert, was den dringenden Bedarf an menschlicher Kontrolle bei der Nutzung KI-generierter Inhalte unterstreicht.